Als unser Team die Schnellladestation CPE250 entwarf, wussten wir, dass ein 10-Zoll-Touch-Display das allgemeine Benutzererlebnis entscheidend verbessern würde. Ziemlich einfache Aufgabe, oder? Für ein Produkt, das nur drinnen eingesetzt oder in der Hosentasche getragen wird, vielleicht. Aber für eines, das im Freien Anwendung findet? Das ist schon eine größere Herausforderung.

Touchscreens sind echte Sensibelchen

Touchscreens werden in der Regel auf Glas oder andere kurzlebige Materialien geklebt. Dies funktioniert in den meisten Fällen gut, aber sicherlich nicht bei einer Ladestation im Freien. Bedenken Sie die zahlreichen Einflüsse in freier Natur, die ein weniger widerstandsfähiges Touchscreen-Display beschädigen könnten: Hagel, ein durch ein Auto aufgewirbelter Stein oder vom Wind verwehte Zweige, um nur einige zu nennen. Noch schlimmer ist, dass die Verklebung, die zum Anbringen von Touchscreens auf Glas verwendet wird, über einen längeren Zeitraum keinen großen Temperaturschwankungen oder direkter UV-Bestrahlung standhält. Der traditionelle Touchscreen kann dem Wetter einfach nicht trotzen.

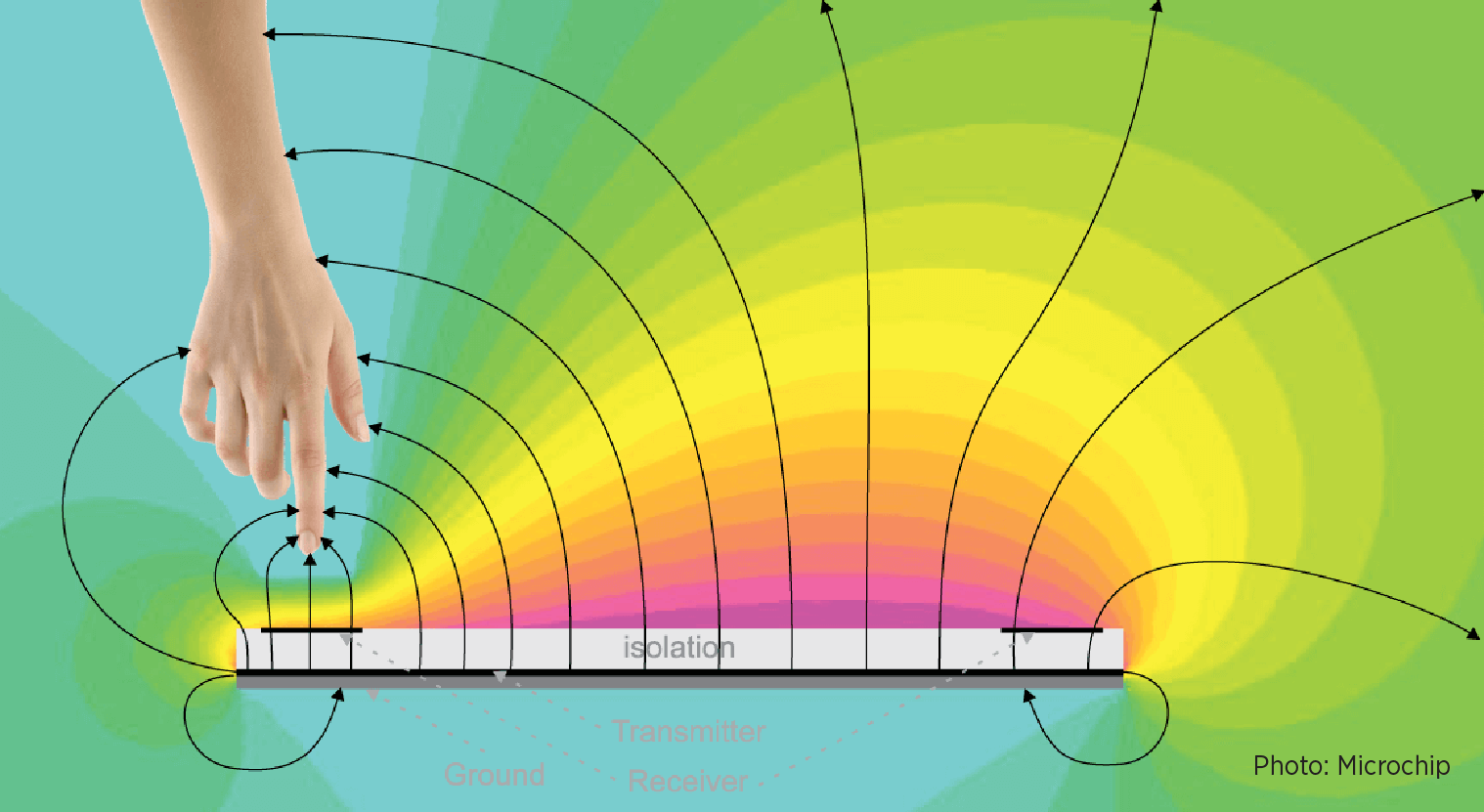

Deshalb haben wir einen neuen Ansatz implementiert: einen auf dem elektrischen Feld (E-Feld) basierenden Controller mit vier Sensoren, positioniert an den Rändern des Displays.

Im Gegensatz zum Touchscreen kann mit dem E-Feld-Controller eine äußerst widerstandsfähige Polycarbonat-Abdeckung zum Einsatz kommen, mit der das Display auch bei extremen Wetterbedingungen geschützt bleibt. Ein E-Feld-Controller, der mit einem einfachen Algorithmus arbeitet, stellt jedoch eine besondere Herausforderung dar: Manchmal wird die XY-Berührungsposition des Benutzers auf dem Display verzerrt.

Verwirrung in der Praxis

Im Gegensatz zu einem Touchscreen, der Berührungen sofort erkennt, sendet der E-Feld-Controller zuerst ein elektrisches Feld aus und erkennt dann die Einwirkung eines Objekts auf dieses Feld. Dieser Betriebsmechanismus führt zu einer Reihe potenzieller Probleme: Er erkennt den gesamten Finger oder andere Finger eines Benutzers anstatt nur die Fingerspitze/den Berührungspunkt, reagiert uneinheitlich auf unterschiedliche Handgrößen und hat Probleme mit der Variabilität verschiedener Interaktionsstile. Ein paar Beispiele: Manche Benutzer halten ihre Finger senkrecht zum Display, andere verwenden den kleinen Finger oder den Zeigefinger, und wieder andere Benutzer halten ihre Hände fast flach am Bildschirm usw.

Um diese Verzerrungen zu verbessern, gab es zwei Möglichkeiten. Erstens: Die Erstellung eines grundlegenden Algorithmus für den Controller und dessen kontinuierliche Anpassung, um Extremfälle abzufangen. Diese Vorgehensweise fühlte sich ineffizient und schlichtweg nicht empfehlenswert an. Dies würde keine Lösung für das zugrunde liegende Problem, sondern eher ein Pflaster sein, welches wiederholt aufgeklebt werden muss.

Zweitens: Das E-Feld-System selbst lernen lassen, wie der Berührungspunkt des Benutzers genau bestimmt werden kann.

Ein auf TensorFlow basierendes Modell für maschinelles Lernen

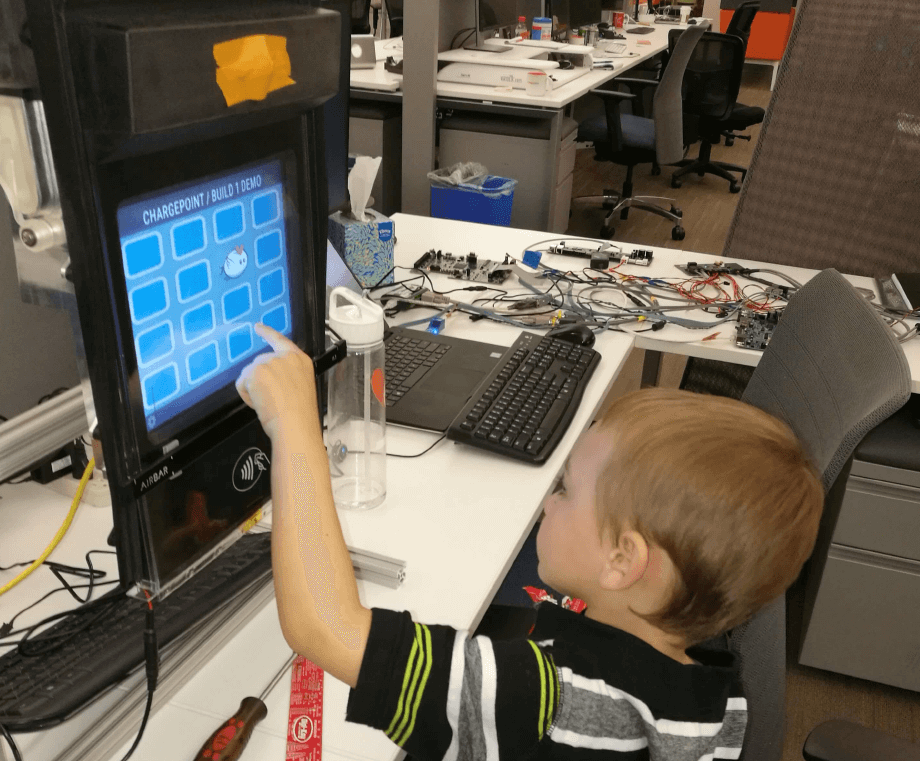

Bevor ein Modell für maschinelles Lernen seine volle Wirkung entfalten konnte, mussten wir es mit genügend Daten versorgen, um es „trainieren“. Dieses Training erforderte die betreffenden Rohdaten (die Messwerte des E-Feld-Controllers) und die richtigen Ergebnisse (die akkuraten XY- Berührungspositionen des Benutzers). Um das Modell zu trainieren, haben wir ein einfaches Legespiel (wie Memory) entwickelt, das den gesamten Bildschirm abdeckt. Verschiedene Benutzer spielten das Spiel, während wir die Messwerte des E-Feld-Controllers zusammen mit Daten zusätzlicher Sensoren aufzeichneten, die die korrekten zugehörigen XY-Positionen bereitstellen konnten.

Die Trainingsdaten wurden dann in TensorFlow eingespeist, einer von Google entwickelten Open-Source-Softwarebibliothek zum Entwerfen, Erstellen und Trainieren von Modellen für maschinelles Lernen. TensorFlow ermöglichte die Erstellung eines neuronalen Netzwerkmodells, das E-Feld-Daten den richtigen XY-Berührungspositionen zugeordnet hat.

Da es sich bei den Ladestationen um eingebettete Systeme handelt, nutzte das Team die C-Bibliothek von TensorFlow, um das exportierte Modell zu laden. An diesem Punkt wurde das Modell „eingefroren“ (sodass es nicht mehr lernte) und war in der Lage, neue Sensorwerte zu übernehmen, sodass es völlig neue XY-Berührungspunkte „vorhersagen“ konnte.

Das Ergebnis? Leistungsstarke Echtzeitprognosen der XY-Berührungspositionen und ein Display, das robust und genau ist. Es ist nicht nur ausreichend vor Witterungseinflüssen geschützt, sondern auch in der Lage, die Berührungen und Gesten eines Benutzers zu erkennen und darauf zu reagieren.

Selbst Winterwetter, Regen oder Fahrhandschuhe können dem Touchscreen nichts anhaben: Wenn Sie also das nächste Mal in der Kälte vor einer CPE250 Station stehen, lassen Sie die Handschuhe ruhig an.

Die hierin enthaltenen Informationen sind urheberrechtlich geschützt und dienen ausschließlich zu Informationszwecken. Sie dürfen ohne vorherige schriftliche Genehmigung von ChargePoint, Inc. weder verwendet noch vervielfältigt werden.